中国科学技术大学陈小平教授“人工智能的重大发展—从实践到思想”线上讲座顺利举行

点击次数: 更新时间:2023-09-17

本网讯(通讯员 唐瑞雪)9月13日晚,应yl23455永利官网陈波教授邀请,中国科学技术大学陈小平教授做客77779193永利科学技术哲学论坛,通过线上平台为师生带来一场题为“人工智能的重大发展—从实践到思想”的讲座。本场讲座由yl23455永利官网陈波教授主持,77779193永利计算机学院蔡恒进教授评议。来自国内外的1200余名听众参与本次线上讲座。

陈波教授首先介绍开展77779193永利科学技术哲学论坛的初衷。77779193永利哲学系曾经聚集了大批科学技术哲学方面的优秀学者,形成了一个连续的传统,希望通过举办此系列讲座来延续和光大这一传统。

陈小平教授首先以AlphaGo 到AlphaGo Zero 的发展为例分析人工智能实践中的历史性跳变。AlphaGO是一款围棋人工智能程序,AlphaGo Zero为其发展的第四代。与前三代的原理不同,AlphaGo Zero 没有关于围棋的任何知识,也没有模仿人类下棋思维,而是通过自搏反推落子胜率,并以胜率估计为评估函数,而胜率估计与对手无关,由此将围棋问题封闭化,即不再通过预测对手的落子来赢得比赛。AlphaGo Zero 是历史上第一台没有运用人类领域知识的智能机器,只以人类发明的人工智能知识和原理为基础,通过自我学习战胜了之前的AlphaGo版本,显示出人工智能的巨大潜力。

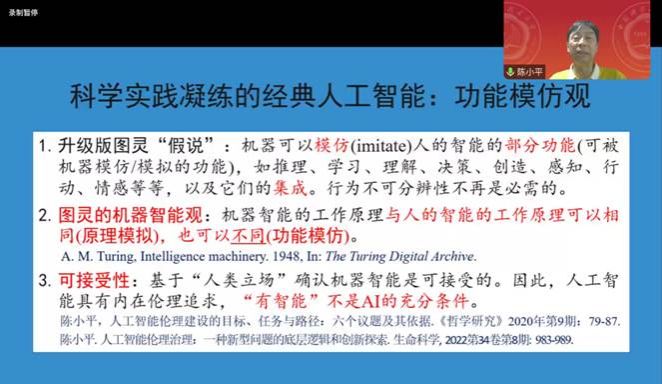

接着,陈小平教授梳理了人工智能思想的发展历史。图灵测试依赖行为的不可分辨,但随着人工智能的发展,行为不可分辨不再必要。人工智能的科学实践表明,即使机器的行为与人的行为是可分辨的,人们仍然有可能认为机器有智能。在现代,人工智能更加强调原理模拟和功能模仿。原理模拟即认为机器采用与人相同的工作原理完成相同的功能。而功能模仿则认为机器采用与人不同的工作原理完成相同的功能。陈小平教授指出人工智能仍以功能模仿为主,并且在总结科学实践的基础上提出了“功能模仿观”。该观点由以下三条原理构成:(1)升级版图灵“假说”:机器可以模仿人的智能的部分功能,如推理、学习、决策等,以及它们的集成。行为不可分辨不再是必需的。(2)图灵的机器智能观:机器智能的工作原理与人的智能的工作原理可以相同,也可以不同。(3)可接受性:基于“人类立场”确认机器智能是可接受的。因此,人工智能具有内在伦理追求,“有智能”不是人工智能的充分条件。

讲座最后,陈小平教授澄清了以往对人工智能的误解,并且分析了当今发展人工智能所带来的种种问题。首先,经典人工智能不是计算主义或功能主义。计算主义认为人心或人脑是计算机,而功能主义认为功能相同的实体是相同的实体。经典人工智能的工作原理与人脑的工作原理不同,因此,它不是计算主义。此外,经典人工智能虽然可以模仿人类智能的部分功能,但是不能将人脑的一切都概括为功能,所以即使经典人工智能可能模仿人脑的部分功能,也不意味两种实体是相同的,因此它不是功能主义。对于机器的理解和人的理解,陈小平教授指出两种理解的原理可以不同,但人工智能研究和人工智能伦理不能脱离可接受性。面对人工智能所引发的可控性问题、合理性问题以及带来的重大社会问题在内的一系列伦理挑战,陈小平教授倾向于将人工智能视为似人非人、似物非物的第三种存在物,这样有利于缓和目前人工智能发展所导致的冲突,缓和人工智能与人之间的对抗性关系。

在评议环节,蔡恒进教授就“术语‘经典人工智能’”、“对于人工智能的可控能否实现”、“为何将人工智能视为第三种存在物”、“人工智能会不会有自我意识”等问题进行提问。蔡恒进教授表示,人类希望人工智能可控与有能力可控之间存在着张力,主张“将人工智能视为第三种存在物”会带来人与第三种存在物的关系之类的问题。与其将人工智能视为第三种存在物,是否可以将其视为人类能力、意图的延伸,以此来缓和目前造成的种种冲突。

陈小平教授回应称,经典人工智能主要指从图灵到各种理论实践,除了经典人工智能外,人工智能还有像类脑这样的其他人工智能。对于可控性问题,陈小平教授认为,必须要坚持对人工智能的可控,但是这个可控性要分为不同的等级。如果过度控制,会限制人工智能的发展。对于人工智能的研究,要有底线,但是目前这个底线在哪、是什么还不确定。如果将人工智能视为第三种存在物,那么可以设定关于第三种存在物的法律、政策等,这可能有利于缓和目前所引发的种种问题。如果不采取这种观点,很可能要么会放松风险管控,要么会限制人工智能的发展。

观众就“为何经典人工智能的发展会使心物二元论不成立”、“为什么大模型不采用AlphaGo Zero 的非人工标注技术”进行提问。陈小平教授分别进行了简单地回应,“心物二元论”是从原理模拟的角度来说的,而人工智能不以原理为标准,其功能与原理不一致,突破了心物二元论。大模型中有两种学习方法。一种为自监督学习,不需要标注;另外一种为监督学习,需要人类进行标注。目前在大模型中主要使用自监督学习,但因为胡说、乱说等现象表明需要进行监督学习。

(编辑:邓莉萍 审稿:严璨)